让FPGA替代GPU,你会有怎样的顾虑?

这几天,已经退役的AlphaGo又强行刷了一波头条,不是又跟哪位世界高手对决,而是“新狗”通过无监督式学习,仅用3天时间就战胜了李世石版的AlphaGo,然后用了21天时间战胜了柯洁版本AlphaGo。AlphaGo让我们真真切切地看到了AI计算的强大。

目前,在AI计算平台使用最广泛的两种加速部件是GPU和FPGA。GPU可适用于具备计算密集、高并行、SIMD(SingleInstructionMultipleData,单指令多数据流)应用等特点的深度学习训练模型领域,并且GPU创建了包含CNN、DNN、RNN、LSTM以及强化学习网络等算法在内的应用加速平台和生态系统。

但是,最近FPGA又频频被各AI领域的巨头看好,比如微软、百度、科大讯飞都对FPGA应用前景有所期待。那么如果让你选择FPGA作为AI计算系统的主力军,你会有什么样的顾虑?

顾虑一:FPGA有啥优势?什么样的场景更适合FPGA?

首先,深度学习包含两个计算环节,即训练和推理环节。GPU在深度学习算法模型训练上非常高效,但在推理时对于小批量数据,并行计算的优势不能发挥出来。而FPGA同时拥有流水线并行和数据并行,因此处理任务时候延迟更低。例如处理一个数据包有10个步骤,FPGA可以搭建一个10级流水线,流水线的不同级在处理不同的数据包,每个数据包流经10级之后处理完成。每处理完成一个数据包,就能马上输出。通常来说,FPGA加速只需要微秒级的PCIe延迟。当Intel推出通过QPI快速通道互联的Xeon+FPGA之后,CPU和FPGA之间的延迟甚至可以降到100纳秒以下。

其次,FPGA是可编程芯片,算法烧录更加灵活。目前来看,深度学习算法还未完全成熟,算法还在迭代衍化过程中,若深度学习算法发生大的变化,FPGA是软件定义硬件,可以灵活切换算法,快速切入市场。

未来至少95%的机器学习计算都是用于推断,只有不到5%是用于模型训练,而FPGA正是强在推断。大幅提升推断效率的同时,还能最小限度损失精确性,这正是FPGA的强项。

责任编辑:任我行

-

碳中和战略|赵英民副部长致辞全文

2020-10-19碳中和,碳排放,赵英民 -

两部门:推广不停电作业技术 减少停电时间和停电次数

2020-09-28获得电力,供电可靠性,供电企业 -

国家发改委、国家能源局:推广不停电作业技术 减少停电时间和停电次数

2020-09-28获得电力,供电可靠性,供电企业

-

碳中和战略|赵英民副部长致辞全文

2020-10-19碳中和,碳排放,赵英民 -

深度报告 | 基于分类监管与当量协同的碳市场框架设计方案

2020-07-21碳市场,碳排放,碳交易 -

碳市场让重庆能源转型与经济发展并进

2020-07-21碳市场,碳排放,重庆

-

两部门:推广不停电作业技术 减少停电时间和停电次数

2020-09-28获得电力,供电可靠性,供电企业 -

国家发改委、国家能源局:推广不停电作业技术 减少停电时间和停电次数

2020-09-28获得电力,供电可靠性,供电企业 -

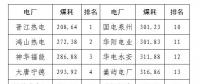

2020年二季度福建省统调燃煤电厂节能减排信息披露

2020-07-21火电环保,燃煤电厂,超低排放

-

四川“专线供电”身陷违法困境

2019-12-16专线供电 -

我国能源替代规范法律问题研究(上)

2019-10-31能源替代规范法律 -

区域链结构对于数据中心有什么影响?这个影响是好是坏呢!